شرکت هوش مصنوعی ویرا سگال کارو

شرکت هوش مصنوعیشرکت هوش مصنوعی ویرا سگال کارو

شرکت هوش مصنوعیالگوریتم گوگل چگونه سایت ها را شناسایی می کند ؟

الگوریتم گوگل چگونه سایت ها را شناسایی می کند ؟

در این مطلب می خواهم برای شما راجع به الگوریتم گوگل بیشتر توضیح دهم.

الگوریتم گوگل بر پایه هوش مصنوعی کار میکند و عکس العمل های بسیار جالبی دارد.

برای همه پیش آمده که برای جستجوی چیز خاصی به گوگل مراجعه کردیم. این جستجو ها و نتایجی که نشان داده می شود توسط یک الگوریتم خاصی کار می کنند.

حال این سوالات پیش می آید که گوگل چگونه سایت ها را پیدا می کند و چگونه تصمیم می گیرد که کدام سایت ها را در رده های بالاتر نشان دهد؟ و یا اینکه سئو چیست؟

این گوگل است که تصمیم میگیرد کدام پرسش به چه طریقی به سایت های مختلف متصل شود. ما در ادامه به شما توضیحاتی را می دهیم که بتوانید راحت تر ساز و کار موتور جستجو را درک کنید.

موتور هایی مانند گوگل چگومه محتوا را پیدا می کنند؟

گوگل با استفاده از کدی به نام “عنکبوت” وب را می گردد و یا به اصطلاح می خزد. این یک برنامه کوچک است که پیوندها را از یک صفحه به صفحه دیگر دنبال می کند و هر صفحه ای که روی آن قرار می گیرد کپی شده و به سرورها منتقل می شود.

شبکه اینترنت بسیار بزرگ است و به همین ترتیب اگر گوگل بخواهد همه محتوای خود را ثبت کند ، غیرقابل کنترل است. به همین دلیل است که گوگل فقط کد صفحه را ضبط می کند و صفحاتی را که فکر نمی کند مفید باشند (نسخه های کپی ، کم ارزش و غیره) را حذف می کند.

وقتی مقدار زیادی تولید محتوا دارید ، به روشی برای میانبر آن محتوا نیاز دارید. Google نمی تواند فقط یک پایگاه داده بزرگ داشته باشد که شامل همه صفحات باشد ، و هر زمان که سوالی وارد می شود مرتب شوند. این خیلی کند خواهد بود.

در عوض ، آنها یک نمایه ایجاد می کنند یا به اصطلاح ایندکس می کنند که اساساً این روند را میانبر می کند. موتورهای جستجو با استفاده از فناوری مانند Hadoop مقدار زیادی از داده را خیلی سریع مدیریت و پرس و جو می کنند. جستجوی فهرست بسیار سریعتر از جستجوی کل پایگاه داده در هر زمان است.

الگوریتم گوگل چگونه سایت ها را شناسایی می کند ؟

هنگامی که بهینه سازی یا همان ایندکس انجام شد، گوگل نسخه ای از آن را گرفته و یک میانبر برای صفحه در فهرست قرار داده است. عالی است ، هر جستجوی شما در Google احتمالاً هزاران نتیجه دارد ، بنابراین اکنون گوگل باید تصمیم بگیرد که با چه نظمی نتایج را نمایش می دهد.

این واقعاً در قلب سئو و سئو کار است که فاکتورهای تنظیم کننده برای دستکاری ترتیب نتایج را مشخص می کند. الگوریتم یک اصطلاح عمومی است که به معنی یک فرایند یا مجموعه قانون است که برای حل یک مسئله دنبال می شود.

با مراجعه به گوگل ، این مجموعه معیارهای وزنی است که ترتیب رتبه بندی آنها در صفحه را تعیین می کند. الگوریتم گوگل رمانند گذشته ناشناخته نیست و عوامل فردی و معیارهایی که از آن ساخته شده است کاملاً مستند است.

ما می دانیم که همه معیارهای اصلی درون صفحه ای و خارج از صفحه چیست. نکته مهم در درک وزن یا همبستگی بین آنها است.

معیار اول URL است. کلمات کلیدی ممکن است در URL نشان داده شود ، مانند: www.recipes.com/chocolate-cake

معیار دوم بکلینک ها هستند.البته باید دقت داشته باشید که اگر کلمه کلیدی در URL نمایش داده شود انتظار می رود که در بک لینک ها هم نمایش داده شوند.

تمام فاکتورهای مختلفی که گوگل بررسی می کند روی یکدیگر تأثیر می گذارند. هر یک ممکن است ارزش کم و بیش داشته باشد (در وزن دهی) و رابطه بین آنها دائماً تغییر می کند.

گوگل هر ساله صدها به روزرسانی را انجام می دهد و مرتباً این کار در الگوریتم گوگل انجام می شود. معمولاً این رابطه و وزن دهی است که بیش از خود معیارها تغییر می کند.

امیدوارم اطلاعات مفیدی در مورد الگوریتم گوگل به شما داده باشم.

کارشناسان ما تخصص خوبی در الگوریتم گوگل دارند و برای حضور موفق شما در دیجیتال مارکتینگ همیشه در کنار شما حضور خواهند داشت.

در مطالب آینده بیشتر از الگوریتم گوگل برای شما خواهم نوشت.

با برترین اپراتور هوش مصنوعی ایران همراه باشید

کامپیوتر کوانتومی چینی سریعترین در جهان

کامپیوتر کوانتومی چینی سریعترین در جهان

یک کامپیوتر کوانتومی طراحی و ساخت چینی می تواند مسئله ای را که یک ابر کامپیوتر در دو و نیم میلیارد سال حل می کند را در دویست ثانیه حل کند. این کامپیوتر در دانشگاه علم و صنعت در هفی چین توسعه یافته است ، و توجه جهانیان را به دلیل سرعت پردازش بالا را به خود اختصاص داده است. طبق یافته های منتشر شده در Science و گزارش شده توسط Nature ، سیستم جدید ظاهراً اولین نمایش قطعی “برتری کوانتومی” با استفاده از پرتوهای لیزر است که از نظر ریاضی با استفاده از رایانه های باینری سنتی امکان پذیر نیست.

آیا کامپیوتر کوانتومی چینی از کامپیوتر گوگل سریع تر است ؟

سال گذشته ، هنگامی که Google اعلام کرد کامپیوتر کوانتومی Sycamore به برتری کوانتومی دست یافته است، عناوین اصلی اخبار جهان را به خود جلب کرد. Sycamore می تواند محاسباتی را در 200 ثانیه انجام دهد که برای سریعترین ابر رایانه ها حدود 10 هزار سال طول می کشد. اخیراً ، چین یک سیستم محاسبات کوانتومی را توسعه داده است که گزارش می شود 10 میلیارد بار سریعتر از Google’s Sycamore است. محققان دانشگاه علم و صنعت چین توضیح دادند که این نمونه اولیه رایانه ای کوانتومی به نام جیژانگ در چند دقیقه نتیجه ای گرفت که بیش از 2 میلیارد سال برای سومین ابر رایانه قدرتمند جهان زمان می برد.

طبق گزارش مجله Science ، جیژانگ می تواند حداکثر 76 فوتون را از طریق نمونه گیری بوزون گوسی ، یک الگوریتم شبیه سازی استاندارد ، که از ذرات نور ارسال شده از طریق یک مدار نوری برای اندازه گیری خروجی استفاده می کند ، تشخیص دهد. نمونه گیری بوسون توسط اسکات آرونسون و الکس آرخیپوف در سال 2011 به عنوان روشی آزمایشی برای اثبات برتری کوانتومی ابداع شد. در اینجا توزیع احتمال بسیاری از بوزون ها (یک ذره اساسی که شامل فوتون ها است) محاسبه می شود.

احتمال تشخیص بوزون در یک موقعیت معین را می توان از یک معادله در بسیاری از موارد ناشناخته محاسبه کرد.لو چائویانگ ، استاد مسئول آزمایش در USTC اظهار داشت که جیوژانگ با دستکاری ذرات نور به موفقیت بزرگی دست یافت. این فرایند متفاوت از رویکردی است که توسط گوگل استفاده شده است ، و از فلز ابررسانا برای ساخت مدارهای کوانتومی برای دستکاری کیوبیت ها استفاده کرده است. Qubits یا کوانتوم بیت مترادف با بیت های باینری کامپیوتر کلاسیک است ، اما بر خلاف بیت های باینری ، می تواند به طور همزمان در بسیاری از حالت ها وجود داشته باشد.

آیا هیچ رقیبی برای جیوژانگ وجود ندارد ؟

رویکرد مشابهی نیز توسط IBM اعمال شده است. هر دو غول فناوری مبالغ زیادی را در مدارهای ابررسانا سرمایه گذاری کرده اند تا تحقیقات محاسبات کوانتومی را تا سر حد ممکن پیش ببرند. در همین حال ، هانی ول و IonQ در حال توسعه معماری های رایانه ای جایگزین کوانتومی هستند که شامل به دام انداختن یون ها باشد. علاوه بر این ، رایانه کوانتومی Silicon Quantum در استرالیا برای سیستم های کوانتومی خود از کیوبیت های سیلیکون چرخشی استفاده می کند.

در مقایسه ، برای جیوژانگ ، تیم تحقیقاتی به سرپرستی فیزیکدان کوانتوم جیان وی پان در دانشگاه علم و صنعت چین ، یک دستگاه بزرگ رومیزی متشکل از لیزر به عنوان منبع نور و تقسیم کننده پرتو برای کمک به ایجاد فوتون های جداگانه ، ایجاد کردند. صدها منشور و ده ها آینه برای فراهم کردن مسیرهای تصادفی برای حرکت فوتون ها استفاده شده اند.مجله Wired اشاره می کند که می توان تصور کرد که هر فوتونی که در پایان فرآیند خوانده می شود تقریباً معادل خواندن یک کیوبیت روی پردازنده ای مانند Google است که نتیجه محاسبه را نشان می دهد.

محققان کامپیوتر کوانتومی چینی ، جیوژانگ را، به 300 جدا کننده پرتو و 75 آینه مجهز کردند. در حین اجرای آزمایشی به مدت 200 ثانیه ، حداکثر 76 کلیک فوتونی خروجی مشاهده شد در حالی که متوسط تعداد فوتون شناسایی شده توسط نمونه اولیه 43 است. در مقایسه ، ابر رایانه چینی ، TaihuLight ، 2.5 میلیارد سال طول می کشید تا به همان نتیجه برسد.

از جیژانگ نمی توان بلافاصله در برنامه های واقعی استفاده کرد. برای انجام محاسبات مختلف این کامپیوتر نیاز به کار با تراشه قابل برنامه ریزی دارد. همچنین پرداختن به شایعات در مورد تهدید آن برای ارز رمزنگاری شده ، یا هرگونه رمزگذاری مورد استفاده در سیستم های مالی ، ارتباطی و دولتی در حال حاضر ؛ گزارش شده است که جیوژانگ قادر به حل مشکل فاکتورینگ نیست که برای رمزگشایی اطلاعات رمزگذاری شده بسیار مهم است.

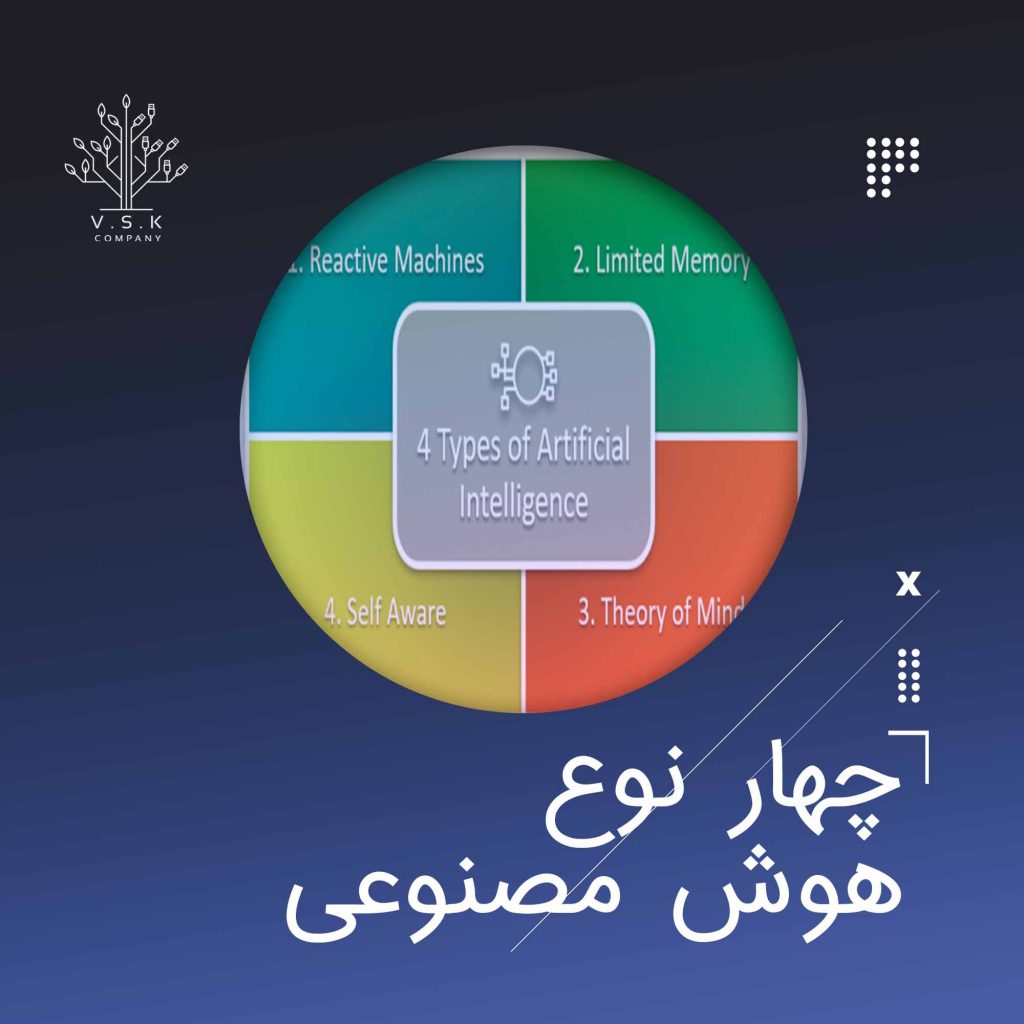

انواع هوش مصنوعی

انواع هوش مصنوعی

با کمک انواع هوش مصنوعی امروزه این فناوری نه تنها با ما صحبت می کند بلکه اتومبیل ها را

کنترل می کند بازی های کامپیوتری انجام می دهد و تمام این کار ها را بهتر از ما انسان ها

انجام می دهد. به نظر می رشد که در مدت زمان کوتاهی هوش مصنوعی ذدر میان ما راه برود.

دیدگاه متداول و مکرر آخرین موفقیت در تحقیقات هوش مصنوعی این است که ماشین های هوشمند

به زودی در دسترس همگان قرار خواهند گرفت. گزارش جدید کاخ سفید در مورد هوش مصنوعی

دیدگاه کاملاً بدبینانه ای در مورد این رویا دارد. این گزارش می گوید که طی 20 سال آینده به احتمال

زیاد در ماشین آلات “اطلاعات کاملاً قابل اجرا قابل مقایسه با انسانها یا بیش از آنها” مشاهده نخواهد شد.

انواع هوش مصنوعی کدامند ؟

ماشین های واکنش پذیر

ابتدایی ترین انواع سیستم های هوش مصنوعی کاملاً واکنشی هستند و نه توانایی تشکیل خاطرات و نه استفاده

از تجربیات گذشته برای اطلاع رسانی تصمیمات فعلی را دارند. Deep Blue ، ابر رایانه شطرنج باز IBM

، که در اواخر دهه 1990 استاد بزرگ بین المللی گری کاسپاروف را شکست داد ، نمونه عالی این نوع ماشین ها است.

Deep Blue می تواند مهره های روی صفحه شطرنج را شناسایی کرده و از نحوه حرکت هر یک مطلع شود. این

کامپیوتر می تواند پیش بینی کند که ممکن است حریف چه حرکات بعدی داشته باشد. و می تواند بهینه ترین حرکت ها

را از بین احتمالات انتخاب کند.اما هیچ مفهومی از گذشته و هیچ خاطره ای از آنچه قبلاً اتفاق افتاده ندارد. جدا از

یک قانون خاص شطرنج که به ندرت استفاده می شود که در مورد تکرار سه بار حرکت مشابه است ، Deep Blue

همه چیز را قبل از لحظه حال نادیده می گیرد. تمام آنچه که انجام می دهد این است که به مهره های موجود

در صفحه شطرنج در حال حاضر نگاه می کند و حرکت های بعدی را انتخاب می کند. این مدل از انوع هوش مصنوعی

جهان را به صورت مستقیم درک می کند و براساس آنچه می بیند عمل می کند. این نوع از هوش به مفهوم درونی جهان

متکی نیست. در یک مقاله اساسی ، رادنی بروکس ، محقق هوش مصنوعی استدلال کرد که ما فقط باید ماشین هایی از این

دست بسازیم. دلیل اصلی او این بود که مردم در برنامه نویسی دقیق دنیاهای شبیه سازی شده برای استفاده کامپیوترها

مهارت ندارند ، چیزی که در بورس تحصیلی AI “نمایندگی” جهان نامیده می شود.

حافظه محدود

این کلاس نوع دوم از انواع هوش منصوعی شامل ماشین هایی است که می توانند به گذشته نگاه کنند. اتومبیل های

خودران هم اکنون برخی از اسین کارها را انجام می دهند به عنوان مثال ، آنها سرعت و جهت اتومبیل های دیگر

را مشاهده می کنند.این کار فقط در یک لحظه امکان پذیر نیست ، بلکه به شناسایی اشیا به صورت خاص و نظارت

بر آنها در طول زمان نیاز دارد. این مشاهدات به المان های از پیش برنامه ریزی شده اتومبیل های خودران اضافه

می شوند که شامل خط کشی خیابان ها ، چراغ راهنمایی و سایر عناصر مهم مانند پیچ های جاده می شوند. هنگامی

که اتومبیل تصمیم می گیرد که خط عوض کند یا از تصادف با سایر اتومبیل ها کهدر جهات گوناگون حرکت می کنند

جلوگیری کند، تمامی مواردی را که ذکر شد را مد نظر قرار می دهد. اما این اطلاعات ساده درباره گذشته فقط گذرا

هستند. آنها به عنوان بخشی از کتابخانه تجربه اتومبیل که می تواند از آن یاد بگیرد عمل نمی کنند، شیوه ای که انسان ها

در هنگام رانندگی به آن صورت عمل می کنند.

نظریه ذهن

در این نقطه تفاوت بین ماشین هایی که تا کنون ساخته ایم و ماشین هایی که در آینده آنها را خواهیم ساخت مشخص می شود.

ماشین آلات در کلاس بعدی که پیشرفته تر است ، نه تنها تمثال هایی را درباره جهان دارند ، بلکه عوامل یا موجودیت های دیگر

در جهان را نیز تشخیص می دهند. در روانشناسی ، این “تئوری ذهن” نامیده می شود مفهوم این تئوری درک این مسئله است که

افراد موجودات و اشیا می توانند استدلال و احساسات منحصر به فرد خود را داشته باشند گکه بر روی رفتار و عملکرد خودشان

تاثیر می گذارد. این نوع درک برای چگونگی تشکیل جوامع انسانی بسایر حیاتی است. بدون داشتن همچون درکی از اطراف و

فهمیدن قصد از انجام کار های مختلف،در بهترین حالت تشکیل جوامع بسیار سخت خواهد وبود و در بدترین حالت تشکیل جوامع

غیر ممکن می شود. اگر سیستم های هوش مصنوعی واقعاً بخواهند در میان ما گام بردارند ، باید بتوانند درک کنند که هر یک از

ما افکار و احساسات و انتظاراتی از نحوه رفتار با ما داریم. و آنها باید رفتار خود را متناسب با آن تنظیم کنند.

خود آگاهی

مرحله آخر توسعه هوش مصنوعی ساخت سیستم هایی است که بتوانند بازنمایی و خود آگاهی درباره خودشان ایجاد کنند. درنهایت ،

محققان هوش مصنوعی نه تنها باید هوشیاری را درک کنند بلکه باید ماشین هایی بسازند که دارای آن باشند. این عملکرد، به تعبیری ،

شاخه ای از “نظریه ذهن” است که توسط هوش مصنوعی نوع سوم اعمال می شود. به یک دلیل به آگاهی “خودآگاهی” نیز گفته می شود.

برای مثال وقتی می گوییم من آن مورد را می خواهم یک جمله بسیار متفاوتی نسبت به من می دانم که آن مورد را می خواهم است.

موجودات هوشیار از خود آگاه هستند ، از حالات درونی خود اطلاع دارند و قادر به پیش بینی احساسات دیگران هستند. ما تصور می کنیم

شخصی که در ترافیک پشت سر ما بوق می زند عصبانی یا بی تاب است ، زیرا وقتی برای دیگران بوق می زنیم چنین احساسی داریم.

بدون نظریه ذهن ، ما نمی توانیم چنین استنباط هایی داشته باشیم.

هوش مصنوعی و داده کاوی

در هوش مصنوعی و یادگیری ماشینی ، داده کاوی یا کشف دانش در پایگاه های اطلاعاتی ،

استخراج غیرمعمول اطلاعات ضمنی ، از قبل ناشناخته و بالقوه مفید از داده ها .است. در این

رویکرد از روش های آماری استفاده می شود که باعث می شود روندها و سایر روابط در

پایگاه های داده بزرگ شناسایی شوند. دلیل عمده اینکه داده کاوی جلب توجه کرده است،

دسترسی گسترده به داده های عظیم و نیاز به تبدیل این داده ها به اطلاعات و دانش مفید

می باشد. از این اطلاعات به دست آمده می تواند برای برنامه های مختلف مانند نظارت بر

ریسک ، مدیریت تجارت ، کنترل تولید ، تجزیه و تحلیل بازار ، مهندسی و اکتشاف علوم

استفاده شود.

انواع تکنیک ها و روش های داده کاوی در هوش مصنوعی

به طور کلی سه روش داده کاوی وجود دارد. یکی از این روش ها تجزیه وتحلیل هم بستگی است.

کشف قوانین تداعی گرایی است که شرایط مقدار ویژگی را نشان می دهد که اغلب با هم در یک

مجموعه داده خاص رخ می دهد. تجزیه و تحلیل همبستگی به طور گسترده ای برای شناسایی همبستگی

محصولات جداگانه در سبد خرید استفاده می شود. تجزیه و تحلیل رگرسیوندومین گزینه در این زمینه

است. تحلیل رگرسیون مدل هایی را ایجاد می کند که متغیرهای وابسته را از طریق تجزیه و تحلیل

متغیرهای مستقل توضیح می دهند. به عنوان مثال ، پیش بینی عملکرد فروش محصول می تواند با

همبستگی قیمت محصول و سطح متوسط درآمد مشتری ایجاد شود. نوع آخر طبقه بندی و پیش بینی

است. طبقه بندی فرآیند طراحی مجموعه ای از مدل ها برای پیش بینی کلاس اشیایی است که برچسب

کلاس آنها ناشناخته است. مدل مشتق شده ممکن است در اشکال مختلف ، مانند قوانین اگر- پس (if-then)

، درخت تصمیم ، یا فرمول های ریاضی نشان داده شود. درخت تصمیم یک نمودار است که ساختاری شبیه به

درخت دارد که در آن هر گره یک آزمون را روی مقدار ویژگی نشان می دهد ، هر شاخه نشان دهنده نتیجه

آزمایش است و هر برگ درخت یک کلاس یا کلاس توزیع را نشان می دهد. درختان تصمیم را می توان به

قوانین طبقه بندی تبدیل کرد. برای پیش بینی برچسب کلاس داده می توان از طبقه بندی استفاده کرد.

پیش بینی شامل شناسایی روند توزیع بر اساس داده های موجود می باشد.

فرایند داده کاوی

هوش مصنوعی و داده کاوی دو معقوله ای هستند که از هم نمی توان جدا کرد. فرایند داده کاوی شامل یک

توالی تکراری از این مراحل است:

انسجام و تمیز کردن داده ها برای حذف ناهنجاری ها و داده های متناقض

ادغام داده ها به گونه ای که ممکن است چندین منبع داده با هم ترکیب شوند

انتخاب داده که در آن داده های مربوط به تجزیه و تحلیل بازیابی می شود

تبدیل داده ها در جایی که داده ها به فرم های مناسب استخراج تلفیق می شوند

برای استخراج الگوها جدید، از الگوها و تکنیک های آماری استفاده می شود

ارزیابی الگو برای شناسایی الگوهای جالب نشان دهنده اطلاعات

از تکنیک های تجسم برای ارائه اطلاعات استخراج شده به کاربران استفاده می شود

محدودیت های داده کاوی

وارد شدن و خارج شدن اطلاعات با کیفیت پایین به داده کاوی نسبت داده می شود زیرا

زیرا کیفیت اطلاعات به دست آمده از داده کاوی به کیفیت داده های تاریخی بستگی دارد.

ما می دانیم که مغایرت داده ها و برخورد با چندین منبع داده مشکلات بزرگی را در مدیریت

داده ایجاد می کند. تکنیک های تمیز کردن داده ها برای مقابله با شناسایی و از بین بردن

خطاها و ناسازگاری ها برای بهبود کیفیت داده ها استفاده می شود. با این حال ، تشخیص

این ناسازگاری ها بسیار دشوار است. چگونه می توانیم تبادلی را شناسایی کنیم که به

اشتباه به عنوان مشکوک برچسب گذاری شده است؟ یادگیری از داده های نادرست منجر

به مدل های نادرست می شود محدودیت دیگر داده کاوی این است که فقط اطلاعات محدود به

مجموعه خاص داده های تاریخی را استخراج می کند و پاسخ ها را فقط می توان با توجه به

روندهای قبلی آموخته شده از داده ها بدست آورد و تفسیر کرد. این توانایی فرد را برای بهره مندی

از روندهای جدید محدود می کند. از آنجا که درخت تصمیم به طور خاص در مجموعه داده های

تاریخی آموزش دیده است ، شخصی سازی درخت را در بر نمی گیرد. علاوه بر این ، داده کاوی

غیر افزایشی است و در هنگام تولید سازگار نیست.

مزایای داده کاوی

داده کاوی به شرکت های بازاریابی کمک می کند مدل هایی را بر اساس داده های تاریخی بسازند

تا پیش بینی کنند چه کسی به فعالیت های بازاریابی جدید مانند نامه های مستقیم ، کمپین بازاریابی

آنلاین و غیره پاسخ خواهد داد. از طریق نتایج ، بازاریابان رویکرد مناسبی در فروش محصولات

سودآور به مشتریان هدف خواهند داشت. داده کاوی همانند بازاریابی ، مزایای زیادی را برای

شرکت های خرده فروشی به همراه دارد. از طریق تجزیه و تحلیل سبد بازار ، یک فروشگاه می تواند

یک ترتیب تولید مناسب داشته باشد به گونه ای که مشتریان بتوانند خرید مکرر محصولات دلپذیر را

دارا باشند. علاوه بر این ، همچنین به شرکت های خرده فروشی کمک می کند تا تخفیف های خاصی

را برای محصولات خاص ارائه دهند که مشتریان بیشتری را به خود جلب کند. داده کاوی به موسسات

مالی اطلاعاتی در مورد وام و گزارشگری اعتبار می دهد. با ساخت یک مدل از داده های مشتری تاریخی ،

بانک و موسسه مالی می توانند وام های خوب و بد را تعیین کنند. علاوه بر این ، داده کاوی به بانک ها کمک

می کند تا معاملات جعلی کارت اعتباری را برای محافظت از صاحب کارت اعتباری شناسایی کنند. با استفاده

از داده کاوی در داده های مهندسی عملیاتی ، تولید کنندگان می توانند تجهیزات معیوب را شناسایی کرده و

پارامترهای کنترل بهینه را تعیین کنند. به عنوان مثال ، تولیدکنندگان نیمه هادی این چالش را دارند که حتی شرایط

محیط های تولید در کارخانه های مختلف تولید ویفر مشابه است ، کیفیت ویفر بسیار یکسان است و برخی به دلایل

نامعلوم حتی دارای نقص هستند. داده کاوی برای تعیین دامنه پارامترهای کنترلی که منجر به تولید ویفر طلایی

می شود مورد استفاده قرار گرفته است. سپس از آن پارامترهای کنترل بهینه برای تولید ویفر با کیفیت مطلوب

استفاده می شود.

هوش مصنوعی,برترین اپراتور,طراحی سایت,هوش مصنوعی چیست

هوش مصنوعی و سیستم های خبره

هوش مصنوعی و سیستم های خبره

در هوش مصنوعی و علوم کامپیوتری، سیستم خبره یک سیستم رایانه ای است که توانایی تصمیم گیری یک متخصص انسانی را تقلید می کند. سیستم های خبره برای حل مشکلات پیچیده با استدلال از طریق دانش ، که به طور عمده به عنوان قوانین و نه از طریق آیین دادرسی مرسوم نشان داده می شود ، طراحی شده اند. اولین سیستم هایی که خبره نامیده شدند در دهه 1970 ایجاد و سپس در دهه 1980 گسترش یافت. سیستم های خبره از اولین اشکال واقعاً موفق نرم افزار هوش ماشینی(AI) بودند. یک سیستم خبره به دو زیر سیستم تقسیم می شود: موتور استنتاج و دانش بنیان. پایگاه دانش بیانگر حقایق و قوانین است. موتور استنتاج برای استنتاج حقایق جدید قوانین را در مورد حقایق شناخته شده اعمال می کند. موتورهای استنتاجی همچنین می توانند شامل توانایی توضیح و اشکال زدایی نیز باشند.

هوش مصنوعی و توسعه اولیه سیستم های خبره

در مدت کمی پس از طلوع رایانه های مدرن در اواخر دهه 1940 – اوایل دهه 1950 ، محققان شروع به درک پتانسیل عظیم این ماشین ها برای جامعه مدرن کردند. یکی از اولین چالش ها این بود که چنین ماشینی توانایی “فکر کردن” مانند انسان را داشته باشد. به طور خاص ، ساختن ماشین آلاتی که قادر به تصمیم گیری در موردموارد مهم به روشی است که بشر می گیرد. حوزه پزشکی / بهداشت و درمان چالش جالب توجهی را

بنابراین ، در اواخر دهه 1950 ، درست پس از کامل شدن عصر اطلاعات ، محققان آزمایشاتی را در مورد احتمال استفاده از فناوری رایانه برای تقلید از تصمیم گیری انسان آغاز کردند. به عنوان مثال ، محققان زیست پزشکی شروع به ایجاد سیستم هایی با کمک رایانه برای کاربردهای تشخیصی در پزشکی و زیست شناسی کردند. این سیستم های تشخیص زودهنگام از علائم و نتایج آزمون آزمایشگاهی بیماران به عنوان ورودی برای ایجاد نتیجه تشخیصی استفاده می کردند. این سیستم ها اغلب به عنوان اشکال اولیه سیستم های خبره توصیف می شدند. با این حال ، محققان دریافته بودند که هنگام استفاده از روش های سنتی مانند نمودارهای جریان مطابقت الگوی آماری ، یا نظریه احتمالات محدودیت های قابل توجهی وجود دارد. تا این ماشین ها را قادر به تصمیم گیری های تشخیصی پزشکی کند.

معرفی رسمی و تحولات بعدی سیستم های خبره

سیستم های خبره به طور رسمی در حدود سال 1965 توسط پروژه برنامه نویسی استنفورد به رهبری ادوارد فیگنبام ، که گاهی اوقات “پدر سیستم های خبره” نامیده می شود ، معرفی شد. دیگر همکاران اصلی اولیه ، بروس بوکانان و راندال دیویس بودند. محققان استنفورد سعی کردند دامنه هایی را که دارای تخصص بسیار ارزشمند و پیچیده هستند ، مانند تشخیص بیماری های عفونی و شناسایی مولکول های آلی ناشناخته (دندرال) را شناسایی کنند. این ایده که “سیستم های هوشمند بیش از آنکه از فرمالیسم های خاص و طرح های استنباطی استفاده کنند از دانش خود برخوردار می شوند همانطور که فیگنباوم گفت ، در آن زمان یک گام مهم به جلو بود ، زیرا تحقیقات گذشته بر روی روشهای محاسباتی ابتکاری ، و اوج آن در تلاش برای توسعه راه حلهای مسئله ای کاملاً عمومی (بیشتر کار مشترک الن نیول و هربرت سایمون) است متمرکز بود. سیستم های خبره به اولین اشکال واقعی موفق هوش مصنوعی (AI) تبدیل شدند.

رویکردهای فعلی به سیستم های خبره

محدودیت های نوع قبلی سیستم های خبره ، محققان را ترغیب به توسعه انواع جدیدی از رویکردها کرده است. آنها به منظور شبیه سازی روند تصمیم گیری انسان ، رویکردهای کارآمد تر ، انعطاف پذیر و قدرتمند تری را ایجاد کرده اند. برخی از رویکردهای محققان مبتنی بر روشهای جدید هوش مصنوعی (AI) و به ویژه در رویکردهای یادگیری ماشین و داده کاوی با مکانیزم بازخورد است. سیستم های مدرن می توانند دانش جدید را با سهولت بیشتری در خود جای دهند و بنابراین خود را به راحتی به روز می کنند. چنین سیستم هایی می توانند از دانش موجود بهتر تعمیم یافته و با مقادیر زیادی از داده های پیچیده سروکار داشته باشند.

معماری نرم افزار

سیستم خبره نمونه ای از یک سیستم دانش بنیان است. سیستم های خبره اولین سیستم های تجاری بودند که از معماری دانش بنیان استفاده کردند. یک سیستم دانش بنیان اساساً از دو زیر سیستم تشکیل شده است: دانش بنیان و موتور استنتاج. پایگاه دانش بیانگر حقایقی در مورد جهان است. در سیستم های خبره اولیه مانند Mycin و Dendral ، این حقایق عمدتاً به عنوان ادعاهای مسطح درباره متغیرها نشان داده می شدند. در سیستم های خبره بعدی که با پوسته های تجاری توسعه یافتند ، دانش بنیان ساختار بیشتری به خود گرفت و از مفاهیم برنامه نویسی شی گرا استفاده کرد. جهان به عنوان کلاس ها ، زیر کلاس ها و نمونه ها نمایش داده شد و ادعاها با مقادیر نمونه های شی object جایگزین شدند. این قوانین با پرس و جو و ادعای ارزش اشیا کار می کنند. موتور استنتاج یک سیستم استدلال خودکار است که وضعیت فعلی دانش بنیان را ارزیابی می کند ، قوانین مربوطه را اعمال می کند و دانش جدید را در دانش بنیان قرار می دهد. موتور استنتاج همچنین ممکن است دارای توانایی توضیح باشد ، به طوری که می تواند زنجیره استدلال مورد استفاده را برای رسیدن به یک نتیجه خاص با ردیابی مجدد قوانینی که منجر به ادعا شده است ، برای کاربر توضیح دهد.